Ondanks de vooruitgang die is geboekt bij het maken van AI-video’s, is er nog steeds een aanzienlijke hoeveelheid bronmateriaal nodig, zoals headshots vanuit verschillende hoeken of videobeelden, voordat iemand een overtuigend nepversie kan maken van hoe je eruit ziet. Als het gaat om het vervalsen van je eigen stem, is dat een ander verhaal, bv Microsoft-onderzoekers Het heeft onlangs een nieuwe AI-tool onthuld Het kan iemands stem simuleren met slechts een sample van drie seconden van hen praten.

De nieuwe tool, een “Neural Markup Language Paradigm” genaamd VALL-E, is gebouwd op EnCodec audiocompressietechnologie van Meta, dat eind vorig jaar werd onthuld en dat kunstmatige intelligentie gebruikt om audio van beter dan cd-kwaliteit te comprimeren tot datasnelheden die 10 keer kleiner zijn dan zelfs mp3-bestanden, zonder merkbaar kwaliteitsverlies. Meta zag EnCodec als een manier om de kwaliteit van telefoongesprekken te verbeteren in gebieden met een gebrekkige mobiele dekking, of als een manier om de vraag naar bandbreedte voor muziekstreamingservices te verminderen, maar Microsoft maakt gebruik van de technologie als een manier om tekst-naar-spraaksynthese-audio beter te maken. realistisch op basis van een zeer beperkte bronsteekproef.

De huidige teksttransformatiesystemen zijn in staat zeer realistische stemmen te produceren. Daarom klinken de stemmen van intelligente assistenten zo authentiek ondanks dat hun verbale reacties onderweg worden gegenereerd. Maar ze hebben zeer schone trainingsgegevens van hoge kwaliteit nodig, die meestal worden vastgelegd in een opnamestudio met professionele apparatuur. Dankzij de aanpak van Microsoft kan VALL-E bijna ieders stem simuleren zonder weken in een studio door te brengen. In plaats daarvan wordt de tool getraind met Meta Libri-light datasetdat 60.000 uur opgenomen Engelse spraak bevat van meer dan 7.000 unieke sprekers’, geëxtraheerd en verwerkt uit LibriVox audioboeken”, die allemaal openbaar domein zijn.

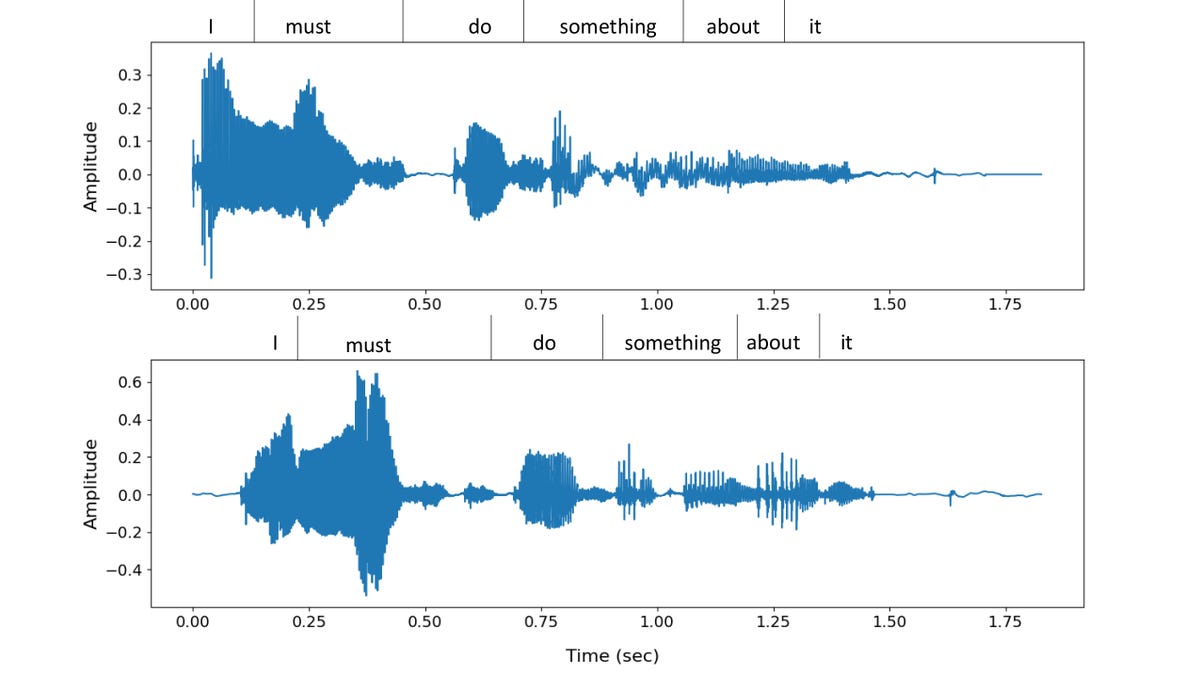

Microsoft heeft een bestand gedeeld Breed scala aan monsters gegenereerd uit VALL-E U kunt dus zelf horen hoe geweldig de mogelijkheden van de onomatopee zijn, maar momenteel zijn de resultaten een allegaartje. De tool heeft soms moeite met het opnieuw creëren van accenten, inclusief zelfs subtiele accenten van bronvoorbeelden waar de spreker Iers klinkt, en het vermogen om het sentiment in een bepaalde zin te verschuiven kan soms grappig zijn. Maar voor het grootste deel produceerde VALL-E samples die natuurlijk en warm klinken en bijna niet te onderscheiden zijn van de originele luidsprekers in de tweede drie bronclips.

Train in zijn huidige vorm door Libre Lite, is VALL-E beperkt tot het simuleren van Engelse spraak, en hoewel de prestaties nog niet vlekkeloos zijn, zal het ongetwijfeld verbeteren naarmate de modeldataset zich uitbreidt. Het is echter aan Microsoft-onderzoekers om VALL-E te verbeteren, aangezien het team de broncode voor de tool niet vrijgeeft. in Recent gepubliceerd onderzoeksartikel De makers van VALL-E beschrijven de ontwikkeling van VALL-E en begrijpen volledig de risico’s die het met zich meebrengt:

Omdat VALL-E spraak kan synthetiseren die de identiteit van de spreker bewaart, kan het potentiële risico’s van modelmisbruik met zich meebrengen, zoals spoofing van spraakherkenning of imitatie van een specifieke spreker. Om deze risico’s te beperken, is het mogelijk om een detectiemodel te bouwen om te onderscheiden of een geluidsfragment is gesynthetiseerd door VALL-E. We zullen ook zetten Microsoft-principes van kunstmatige intelligentie In de praktijk bij het ontwikkelen van modellen.

“Proud coffee guru. Web pioneer. Internet expert. Social media specialist.”